Tutorial ELL

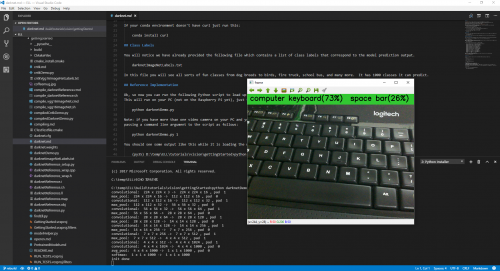

En el último artículo les hablé de la nueva tecnología Embedded Learning Library, después de un par de problemas con las referencias logré correr el ejemplo en mi PC :) aún debo trabajar un poco para correr la demo en mi Raspberry Pi, pero debo reconocer que ha sido divertido, he probado con un par de objetos y el reconocimiento funciona de forma intermitente, algunas veces muy bien, otras no tanto; intenté con algunos objetos que el modelo debería reconocer como teclados, mouse, reloj de arena, etc.

Mi mejor resultado fue con un teclado de computadora, los otros intentos tuvieron un porcentaje muy bajo y por alguna razón muchas cosas fueron identificadas como un modem, de donde sacan suficientes imágenes de un modem para entrenar un modelo en esta época? y aun peor, vale la pena hacerlo? ¯\_(ツ)_/¯

En fin, muchos de los elementos que reconoce el modelo son animales, en cuanto logre montarlo en mi Raspberry lo probaré con mi vieja enciclopedia!

Hasta la próxima!

--Rp